作者:Zihan Liu, Mostofa Patwary, Ryan Prenger,等

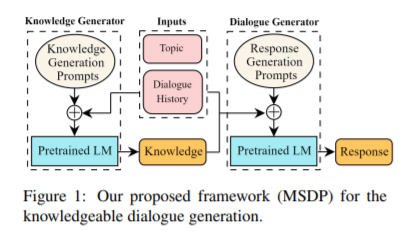

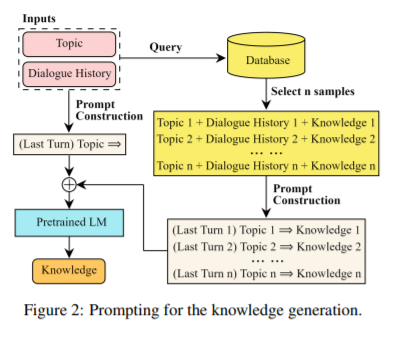

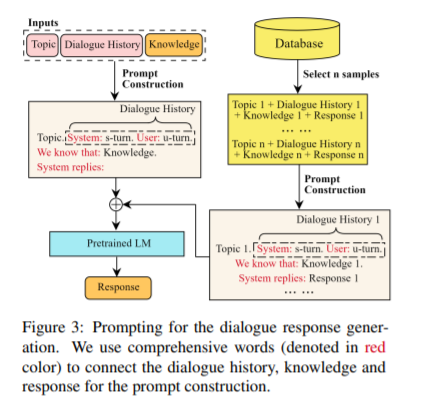

简介:本文在对话系统中进行提示微调的研究与实践。现有的基于知识的对话系统通常使用经过微调的预训练语言模型(LM)和大规模知识库。这些模型通常无法概括知识库之外的主题,每次需要微调时,都需要维护单独的可能较大的检查点。在本文中,作者旨在通过利用预训练LM中存储的固有知识及其强大的生成能力来解决这些限制。作者提出了一种多阶段提示方法,从一个预先训练的LM中生成知识丰富的响应。作者首先提示LM根据对话上下文生成知识。然后,作者进一步提示它根据对话上下文和之前生成的知识生成响应。结果表明,当结合知识相关性和正确性时,作者的知识生成器比最先进的基于检索的模型的性能高5.8%。此外,作者的多阶段提示在反应知识和参与度方面分别比基于微调的对话模式高出10%和5%。再有,作者将该模型扩展到5300亿个参数,并表明更大的LMs可以将生成正确性分数提高高达10%,将响应相关性、知识性和参与度提高高达10%。

论文下载:https://arxiv.org/pdf/2203.08745.pdf

代码下载:https://github.com/NVIDIA/Megatron-LM

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢